ungetestet aber einfach mal für mich und andere zum merken

Schlagwort: Probleme

Google sicherer

Es ist schon ein paar Wochen her, ich wurde im Freundeskreis wegen diverser Computerprobleme (Layer 8) gerufen.

Einer der Probleme war …ach das ist ja schön mit dem Android mailen und chatten…. aber du machst das ja auch am PC, will ich auch…. Und damit gings dann los. PC an, Browser auf, ab zu Tante Google, oben rechts gibts den Button Anmelden, E-Mail-Adresse und Passwort eingeben. Passwort? Ach ja…. Eingegebener Nutzername oder Passwort ist falsch. Nochmal versucht, immer noch falsch.Na dann klick doch mal auf das Fragezeichen hinter dem Hinweis, sicher hilft Tante Google weiter (hoffe ich, hatte ich noch nicht, ich hab meine Passwörter im Kopf oder sonstwo gesichert), aha Handy-Nummer, Erinnerungsfrage, diverse Fragen zur bisherigen Nutzung…… nichts hilft wirklich weiter.

Das Problem dabei war vor allem dem Hilfesuchenden zu vermitteln, dass diese Schritte ja auch von jedem Fremden/Angreifer so durchgeführt werden könnten. Der Anbieter (in dem Fall Google) muss also schon sicher sein, dass die Person, die hier vorgibt das Passwort nur „vergessen“ zu haben, auch wirklich die berechtigte Person ist. (kann ja jeder sagen)

Google hat hier schon so einiges zu bieten und hilft mit Fragen recht weit und durchdacht. Aber wenn man beim Einrichten eines Accounts sorglos ist, keine gültige Mailadresse und/oder Mobilnummer angibt oder diese Daten veraltet sind, hilft es halt nix, wenn das Kind in den Brunnen gefallen ist.

Auch ein noch funktionsfähiges eingeloggtes Android hilft hier nicht weiter. Schliesslich könnte ein verlorenes/gestohlenes Handy ja sonst als Ausgangsbasis für eine „feindliche Übernahme“ des Accounts missbraucht werden. Ok, das war hier nicht der Fall, das Smartphone befindet sich weiterhin im rechtmäßigen Besitz der Person. (In dem Zusammenhang frage ich mich aber auch, was ist zu tun, bei Diebstahl des Mobilgerätes mit einem funktionierenden Google Account, dessen Passwort der Accountinhaber nicht mehr hat *hierfür gerne mal Kommentarfunktion nutzen)

Ende vom Lied war, der alte Account (und noch ein Google-Account mit dem gleichen Problem) liegen jetzt weiter auf dem Androiden, bis der mal das zeitliche segnet und es wurde ein neuer Account erstellt, am PC „…für den ich mir jetzt aber ganz ehrlich ganz sicher das Kennwort notiert habe...“ na dann, die Hoffnung stirbt zuletzt?

Das ganze brachte mich aber mal dazu, meinen eigenen Account zu prüfen, was wäre wenn… Ok alles gut eine valide alternative Mailadresse und eine gültige Handynummer sind hinterlegt. Und falls beides mal irgendwann nicht mehr funktioniert, gibt es für beide noch eine alternative Nummer/Adresse.

Kann eigentlich nix mehr schief gehn oder??? Hm und wenn der Account gehackt wird und auch diese Infos gelöscht, verändert werden?

Vor einigen Tagen wurde ich dann von einem Kollegen auf ein Sicherheitsfeature für meinen Google-Account hingewiesen und gestern habe ich mir das mal selber angeschaut. Es geht um die Zwei-Wege-Authentifizierung.

Jeder der Onlinebanking nutzt kennt die diversen PIN/TAN Verfahren. Es reicht nicht sich einzuloggen, sondern man muss einen einmaligen Code aus einer Liste oder einen temporär generierten Code eingeben, zumindest um eine Aktion, wie Überweisung, anlegen/ändern/löschen eines Dauerauftrages usw. auszulösen.

Dieses Prinzip hat Google aufgegriffen und bietet oben erwähnte Methode optional an, in den Einstellungen zum Google Konto (bitte nicht mit den gmail Einstellungen verwechseln) unter Sicherheit gibt es die Option Bestätigung in zwei Schritten.

Ist diese Option eingeschaltet, wirst du beimLogin ausser nach deinen üblichen Zugangdaten noch nach einem Code gefragt, den du per SMS oder Sprachnachricht am Handy/Telefon bekommst oder aber per App auf deinem Smartphone. Letzteres funktioniert auch wenn das Handy mal kein Netz hat (vergleichbar, mit den kleinen TAN Generatoren die manche Banken ihren Kunden anbieten). Für das Internetcafe im Urlaub oder im Falle eines defekten/nicht verfügbaren Handys gibts dann auch noch eine Liste mit Codes zum ausdrucken. Einfach in die Brieftasche und du bist im Fall der Fälle gewappnet.

Zusätzlich kannst du vertrauenswürdige Rechner (z.B. deinen PC zuhause) als vertrauenswürdig einstufen, an diesem wirst du dann nicht ständig nach diesem Code gefragt.

Welchen Rechner der Anwender als vertrauenswürdig einstuft, muss jeder selber entscheiden, den Rechner im Internetcafe wohl sicher nicht, auch nicht den Firmenrechner und vielleicht auch nicht das Netbook das sich häufig in öffentlichen WLANs verbindet.

Alles in Allem gefällt mir diese Idee und bringt für uns Anwender wieder ein Stück mehr Sicherheit

Zwei-Wege-Grüße DxU

update zum Thema: Heise Artikel vom 26.02.2013 Googles Zwei-Faktor-Authentifizierung ausgetrickst

netcup neue Nameserver

Hier nur eine kleine Info,

am 1.1.12 schaltet netcup seine alten Nameserver ab.

Ab sofort sind aber die neuen schon verfügbar:

nameserver 46.38.225.225 nameserver 78.47.47.47 nameserver 46.38.252.252 |

eichfach in der „/etc/resolv.conf“ austauschen

Mehr Infos gibts hier:

Wen es nicht betrifft, weiterklicken 😉

umstellende Grüße DxU

Der träumerische Ozelot wird bald wach

Am 13.Oktober 2011 erscheint Ubuntu Version 11.10 und hört auf den Namen „Oneiric Ozelot“

(countdown

(countdown freundlich bereitgestellt unfreundlicherweise entfernt von picomol.de)

Bisher habe ich nur mal die 1.Beta auf mein Netbook installiert. Dort habe ich ja vor einigen Wochen mein gut funktionierendes Ubuntu 11.04 einer Testinstallation von Android für die x86 Architektur geopfert. Ein interessantes Projekt, das auf ausgewählter Hardware (z.B. eee-netbooks) auch schon recht ordentlich laufen soll, inkl. LAN,WLAN, Bluetooth, Maus usw. Nur eben nicht auf meinem ideapad, weder das generische noch das Lenovo-Image wollten so recht. Nun das live- also auch das installierte System funktioniert…irgendwie. Mausbedienung ist aber extrem hakelig und bringt die GUI komplett durcheinander. Alternativ stürzt X ständig ab oder friert ein. Aber das Projekt wird hoffentlich weiter voranschreiten und ist auf meine ToDo.

Dann kam besagte Beta von Ubuntu 11.10. Sie lies sich nach einigen Versuchen installieren, aber nach einigen Minuten will das System wohl Energie sparen und der Monitor wird derart dunkel, dass man die Anwendungen oder den Desktop nur noch erahnen kann. Die frische Installation friert dann ein. Ok, lass ich mich eben von der Final überraschen. Bis dahin habe ich meinem Netbook wieder ein Natty spendiert und bei der Gelegenheit gleich mal ein Netinstall versucht, aber auch das scheiterte kläglich, trotz LAN-Verbindung meinte die Installationsroutine, keine oder nicht alle Pakete online zu finden. Irgendwie lässt sich die Installation dann noch beenden, beim reboot, aber wurde ich von einem nicht startenden Grub empfangen. Also wieder das klassische Image auf den Stick und in kurzer Zeit die Installation vom Live-Medium durchgeschnurpelt, die dann auch erwartungsgemäß, wie auch vormals die Alternate-Installation problemlos funktionierte.

Aber die neue Ubuntu-Version ist nicht das einzige Event rund um die Distribution. Schon einen Tag später, also am Freitag den 14.Oktober 2011 beginnt die dreitägige Ubucon, wie im letzten Jahr in Leipzig.

Wer es noch nicht getan hat, schnell noch anmelden und Anmeldegebühr überweisen.

herbstlich träumerische Grüße

sendet euch und dem Ozelot euer DxU

mein erster VServer…

…oder „Der Weg ist das Ziel“

Vor einigen Monaten hat mir ein Mitstreiter von Ubuntu-Berlin ein tolles Angebot gezeigt. Ein V-Server für den schmalen Geldbeutel. Nicht die schnellste Maschine aber doch ein sehr gutes Preis/Leistungsverhältnis

So hat es nicht lange gedauert und ich habe das Teil gemietet, inklusive eigener Domain, einem vorinstalliertem Debian Lenny mit SysCP als Konfigurationsoberfläche. Seit dem habe ich viel von Freunden und Kollegen an neuem Wissen eingeholt, vieles im Netz gelesen und ausprobiert.

Der erste SSH Login, umschauen im System, tja und dann?

SysCP interessante Serverbedienung, aber irgendwie nicht das wa sich will.

Neuinstallation, diesmal Debian Lenny mit vorinstalliertem ISPConfig, schon besser, auch lokalisiert. Aber auch das war nicht wirklich das was ich erwartet habe. Nach eine weiteren Neuinstallation eines „nackten“ Debian Lenny bekam ich von einem Kollegen den Tipp doch einfach mal die Dokumentationen bei HowtoForge zu durchwühlen. Und siehe da, ein ganz tolles Tutorial fand ich dort mit:

Der Perfekte Server – Debian Lenny (Debian 5.0) [ISPConfig 3] (interessant für mich ab Seite 4)

Jetzt wurde es langsam spannend. Aber auch damit war ich nicht wirklich zufrieden. Und irgendwann erinnerte ich mich an Webmin

Ein paar weitere Neuinstallation und ich landete schliesslich bei Ubuntu 9.04 Server. Ja, na endlich mein System der Wahl. Irgendwie fühlte ich mich da gleich ein wenig heimischer. Und mit Webmin und weiteren schlaflosen Nächten vor dem Monitor habe ich nach Wochen jetzt endlich ein System, das auch mal länger als eine Woche meine Experimente übersteht.

Inzwischen läuft ein nur halb konfigurierter Mailserver (dovecot und postfix) ein Apache2 (darüber funktionieren inzwischen auch einige Webseitenversuche und diverse Webfrontends für Serverdienste, wie das erwähnte webmin) und ganz neu ein voll funktionstüchtiger jabber Server, den ich auch mit einem ersten Account bereits selber nutze. Als Server Software kommt hier übrigens ejaberd zum Einsatz,was wohl ein sehr beliebter Server ist, wenn ich mir hier und anderswo die Liste der nutzenden Anbieter anschaue.

Wieder sind Monate ins Land gegangen, mein vServer lief, aber eigentlich habe ich die ganze Zeit nur den jabber Dienst wirklich genutzt, der läuft dafür aber auch die ganze Zeit ohne zu murren.

Email klappte so leidlich, dank Postfix, konnte ich immerhin im Terminal (ssh Login auf dem Server) mit mutt mails senden und empfangen. Dovecot als pop3/imap Server funktioniert und dank SASL sogar TLS verschlüsselt. Nur gab es keinen Weg zum senden per SMTP

Schließlich gabs am Mittwoch mal wieder einen Ubuntu-Berlin Stammtisch in der c-base, entsprechend der so langsam überall entstehenden Weihnachtsstimmung, diesmal mit Gebäck, Stolle, Dominosteinen….. Beim Futtern und gemütlichem Bier wagte ich mich mal wieder an die Konfiguration. Immerhin klappte das Versenden per Mailclient (also SMTP) unverschlüsselt, aber das ist nicht wirklich das Erstrebenswerte. Und dann entpuppte sich einer der Anwesenden (Namen leider entfallen, kann aber gerne seinen Kommentar hier abgeben) als sehr hilfsbereit, kompetent und geduldig. Schliesslich vollbrachten wir das Wunder und seit dem habe ich einen voll funktionstüchtigen Mailserver. Ach ja die entsprechenden Seiten im Wiki von ubuntuusers.de reichten nahezu aus und sind für den Einsteiger weniger verwirrend als das erwähnte HowToForge

Am nächsten Tag gings dann gleich weiter. Diverses stand und steht noch in der ToDo List

- Roundcube als moderner Webmailer

- WordPress

- und ein zum Teil oben schon benötigter funktionierender MySQL Server

- screen

- https (inzwischen laufen die Seiten auch auf Wunsch per https)

- vielleicht erneut webmin (derzeit nach Neuinstallation des Servers nicht wieder bemüht)

WordPress, tja das installierte Ubuntu bringt dafür ein Repository mit, allerdings in einer nicht mehr ganz aktuellen Version 2.7…. Eigentlich benötigt WordPress auch noch eine Datenbankanbindung z.B. an MySQL , allerdings laufen davon eh schon zwei völlig unterforderte DBs auf meinem Hosting-Paket bei Host Europe, also wozu noch eine, zumal Datenbanken eh nie mein Lieblingsthema waren sondern eher Mittel zum oder notwendiges Übel 😉 (alle SQL-Sever-Admins mögen mir verzeihen, aber das Thema hat mich schon immer abgeschreckt). Also einfach in der Datei wp-config.php in der Zeile

define(‚DB_HOST‘, ‚localhost‘);

das ‚localhost‘ mit ‚kochdirk.de‚ ersetzt und schon brauchte ich mich nicht mehr um die Datenbank kümmern. Kleiner Hinweis an der Stelle, in der gleichen Datei gibt es den Eintrag

$table_prefix = ‚wp_‘;

dessen Wert unbedingt geändert werden sollte, wenn auf die genutzte Datenbank mehr als eine WordPress Installation zugreifen soll

Tja, gesagt, getan, alles vorbereitet, im Broweser die Installationsseite aufgerufen.Hierwird nur nach dem gewünschten Namen des Blogs und einer gültigen Mailadresse gefragt, das wars… dachte ich. Nun der Blog war erstellt und lief, in der Datenbank waren die neue Einträge zu sehen, nur die mail kam nie an. In dieser stehen aber die Zugangsdaten zu WordPress. Stimmte da irgendwas mit meinem Postfix nicht? Eigentlich kann die mail doch nur über selbiges gesendet werden? Nach mehreren Versuchen, entschied ich mich letztlich für eine manuelle Installation. Also aktuelles Paket schon lokalisiert von WordPress-Deutschland gezogen, entpackt, dank Tutorials auf genannter Seite und einem geliehenen (danke Waldstepper) Handbuch ging alles ganz schnell und einfach.

Wieder strahlte mich die Installationsseite an und siehe da, es hat sich, schon hier, so einiges bei WordPress (aktuell in Version 3.0.3) getan. Bei unvorbereiteter Konfiguration bietet schon hier das Webfrontend Hilfe an. Ansonsten startet die Einrichtung mit der bekannten Maske, nur dass hier inzwischen ausser den Feldern Blogtitel und E-Mail auch ein erster Benutzername und das Passwort festgelegt werden kann. Also selbst wenndie Mail wiebeschrieben wieder nicht ankommt, ist das Passwort verfügbar. Aber die Mail kam diesmal an 😉

Die ganze Zeit, half mir auch ccm (danke) geduldig per jabber, weil zu den eigentlichen Fragen gleich hundert weitere auftauchten.

Vorerst wird in diesem Blog nicht viel zu lesen sein, ich hab ja genug mit meinen 2 schon vorhandenen Blogs zu tun, aber schaun wir mal, was die Zukunft bringt

Ach ja und zum Thema ISPconfig/sysCP, im Moment glaube ich nicht, dass dies Tools für mich einen wesentlichen Nutzen bringen. Beide erscheinen mir eher hilfreich für ISP’s, zur Domainverwaltung und zum Kundenmanagement. So ist ein angelegter Kunde dort eben noch lange kein User im Linuxsystem mit eigenem $HOME usw. Sicher sind genannte Tools sehr hilfreich für Leute die in diesem Bereich arbeiten. Ich habe aber derzeit eher einen VServer als Spielwiese und Bastelstube. Meine sonstigen Domains verwaltet der Hoster, nicht ich. Eigentlich kann ich das was ich derzeit ausprobiere auch auf einem lokalen System oder in einer VM vollziehen. Aber dann wäre der Server nicht dauerhaft erreichbar oder würde meine Stromrechnung in die Höhe treiben und meinen DSL-Anschluss ständig benötigen. So läuft der Server im Netz und ist über eine echte Domain und IP erreichbar.

Lustig, wie sich sowas nur per Mundpropaganda rumspricht. Einige Leute, denen ich von diesem vServer erzählt habe, wollen sich den jetzt auch bestellen oder haben es gar schon. (und keiner hat bisher gefragt ob da auch ein Windows Server darauf laufen kann *ggg) Vielleicht werden nach diesem Artikel weitere leser auf den Geschmack kommen, nur Mut, ist garnicht so schwer.

DxU grüsst von der dxupara.de

Compiz Fusion und Video

Hallo,

hier bin ich, Bugs, schon wieder mit einem etwas schwammigen Thema. Es soll sich bei diesem Artikel alles um Video unter Compiz drehen. Das Thema steckt voller Tücken.

Hallo,

hier bin ich, Bugs, schon wieder mit einem etwas schwammigen Thema. Es soll sich bei diesem Artikel alles um Video unter Compiz drehen. Das Thema steckt voller Tücken.

Grundlagen

Lange Zeit war so genanntes Tearing bei Videos mit aktivem Compiz gar nicht zu vermeiden. Inzwischen wurden einige Sachen gefixt und optimiert, was die Chance eröffnet, das Ganze ganz gut in den Griff zu bekommen. Was ist Tearing überhaupt?

Wikipedia schreibt dazu:

„Tearing oder Page-Tearing beschreibt grundsätzlich, dass ein kürzlich gerenderter Frame von dem darauf folgenden überlagert wird, sodass das Objekt zerrissen wirkt. Meistens kommt Tearing bei Videospielen vor, weil arbeitslastige Prozesse die Synchronisationsvorgänge behindern können.

Grafikkarten verfügen über einen Front- und einen Backbuffer. Die GPU (Grafikprozessor) schreibt in den Backbuffer, während der Bildschirm aus dem Frontbuffer liest. Danach wechseln Front- und Backbuffer ihre Funktion. (…) Schreibt nun die GPU in einer anderen Geschwindigkeit einen Frame in den Buffer als der Speicher ausgelesen wird, so tauschen während eines Leselaufs die Buffer ihre Funktion. Nun ist aber ein anderes Bild im Buffer gespeichert, welches dadurch an das alte angehängt wird. Um dies zu verhindern wurde ein weiteres Signal eingeführt, welches gegeben wird, wenn das gesamte Frame ausgelesen ist und erst dann die Buffer gewechselt werden.

Das Benutzen von vertikaler Synchronisation (VSync) hilft, dem Tearing vorzubeugen. Eine vertikale Synchronisation verhindert bei Grafikkarten eine Aktualisierung der Bilddaten, während der Bildschirm das Bild aufbaut. Gebräuchliche VSync-Raten sind dabei 60 Hz, 70 Hz, oder 75 Hz, kann aber sogar bis zu 200Hz kommen.“

Wie sich Tearing bemerkbar macht, habe ich mal mit folgendem Screenshot simuliert. Es bilden sich horizontal verlaufende Bruchkanten im Bild, die besonders störend bei horizontalen Bildfahrten auffallen.

Warum ist Compiz so anfällig für Tearing?

Ich weiß nicht, ob „anfällig“ nun das richtige Wort dafür ist, und ob nun Compiz überhaupt der Hauptschuldige ist, ist auch noch eine Frage für sich, aber die Erklärung ist relativ einfach. Hier konkurrieren mehrere Ebenen der Darstellung um die Vorherrschaft und müssen möglichst synchronisiert und zur Kooperation überredet werden, um Tearing zu verhindern. Beim aktuellen Problem haben wir mindestens vier Ebenen, die alle miteinander klar kommen müssen.

- Monitor/Display

- Grafikkarte/Treiber

- Compiz

- Video/Mediaplayer

Monitor/Display

Fangen wir mal ganz außen an. Der Monitor zeichnet das Bild der Grafikkarte mit einer bestimmten Frequenz. Hier kann es von Hersteller zu Hersteller und je nach Displaytyp große Unterschiede geben, was die erwarteten Eingangssignale angeht. Während PC-Monitore in der Regel sehr flexibel sind, beschränken Fernseher oft die akzeptierten Signale. Die aktuellen LG-Fernseher, zum Beispiel, wollen am liebsten 60Hz über ihre HDMI-Eingänge haben, laufen aber auch noch mit 50Hz. Hier kann es aber schon zu ersten Stolperfallen und ruckeligen Bildern kommen, wenn man von den vorgegeben Frequenzen abweicht. Wenn der Monitor also 60 Hz wünscht, sollte auch die Ausgabe der Grafik auf 60 Hz fest eingestellt werden.

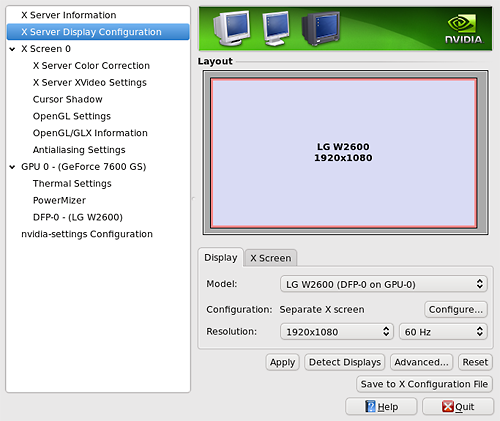

Grafikkarte/Treiber (hier Nvidia)

Direkt hinter dem Monitor sitzt im Grunde der Treiber der Grafikkarte. Genau hier muss man als erstes eingreifen. Im Idealfall stellt man hier die native Auflösung des Displays (bei fullHD Fernsehern 1920 x 1080) und die passende Frequenz ein.

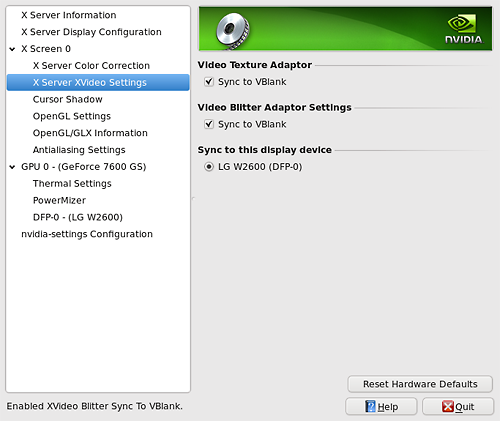

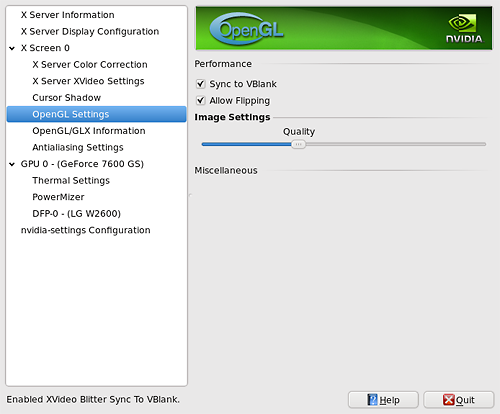

Hier tauchen nun auch das erste mal Optionen zur Synchronisation (Sync to VBlank) auf. Beim Nvidia System sogar gleich an zwei bis drei (je Version) Stellen.

Diese Synchronisations-Optionen sollten alle aktiviert werden. Bei den OpenGL-Einstellungen muss man eventuell noch die Qualität zugunsten der Performance zurückschrauben, wenn der Treiber die zuvor eingestellten Werte für Auflösung und Frequenz nicht akzeptieren will. Hier ist gegebenenfalls ein wenig experimentieren vonnöten.

Compiz

Auch bei Compiz gib es einige Stellschrauben, die überprüft werden sollten. Diese findet man alle im CompizConfig Einstellungsmanager unter dem Bereich Allgemeine Compiz Optionen / Display Settings.

Als erstes sollte die Aktualisierungsrate angepasst werden. Hier sollten wieder die 60 Hz stehen. Zusätzlich ist die Option Aktualisierungsrate erkennen sehr zu empfehlen, da Compiz sich dann sogar Hardware bedingt leicht abweichenden Werten wie 59,95 Hz anpassen kann.

Ganz wichtig ist dann noch der letzte Punkt Mit VBlank synchronisieren. Diese Option muss aktiviert sein, damit Compiz sich im Gleichtakt mit der Grafikkarte bewegen kann.

Video/Mediaplayer

Hier wird es wieder experimentell. Viele Player haben in ihren Settings und Einstellungen Synchronisationsoptionen. Diese sind bezeichnet mit Namen wie VblankSync, SyncVBlanc, VSync oder auch Vertikalsynchronisation. Sie alle wollen das gleiche erreichen: das Synchronisieren der Bildausgabe mit der Grafikkarte und dem Monitor. Soweit so gut und in der Regel ist ein Aktivieren dieser Optionen zu empfehlen, wäre da nicht noch Compiz, der dazwischenfunkt. Es kann durchaus passieren, dass Tearing im Video noch gefördert wird, wenn diese Optionen im Player selbst aktiviert sind. Das allerdings ist auch nicht generell so. Bei mythTV habe ich jedenfalls ein besseres Bild, wenn ich dort bei aktivem Compiz diese Optionen deaktiviere und mich bei der Synchronisation ganz auf Compiz verlasse, der mit seinem Fenstermanager ja Oberfläche und Video zusammenbringt. Hier muss man also ausprobieren, was sich am besten macht. Zum Testen eignen sich Videos mit schnellen Seitwährtsschwenks und Kamerafahrten mit kontrastreichen vertikalen Strukturen, etwa Baumstämme oder Zaunlatten vor einem hellen Himmel.

Checkt also diese ganzen Optionen mal ab und vielleicht ist es Euch dann auch wie mir möglich, Video, TV und DVD ohne Störungen in Fullscreen zu genießen, ohne Compiz temporär deaktivieren zu müssen.

Und was ist mit Flash?

Tja, was soll man dazu sagen? Ich weiß nicht, wie Flash intern arbeitet, aber derzeit bietet es unter Linux keine Möglichkeit, sich irgendwie synchronisieren zu lassen. Compiz bekommt die Sache aber eigentlich gut in den Griff, bei kleinen Flash-Videos sollte es kein Tearing mehr geben, doch zieht Flash aufgrund eines nicht zeitgemäßen Fehlens einer Hardwareunterstützung derart viel Systemlast, so dass es sich bei hohen Auflösungen sehr schnell verschluckt und seine Bildausgabefrequenz nicht mehr halten kann. So kann man bei Flash-Videos in fullHD noch froh über Tearing sein, denn im schlimmsten Fall verkommt ein solcher Film dann schon mal zur Diashow.

Also viel Glück beim Probieren und Optimieren. Und wenn es nicht klappen sollte, tröstet Euch, ich denke, in 5 Jahren ist das alles kein Problem mehr. Dann sind die Sachen noch mehr aufeinander abgestimmt und die Hardware noch ein bisschen flotter und Flash vielleicht endlich weg vom Fenster.

Bis demnächst..

Bugs

KDE4 – Besserungen und Stolpersteine

Wie angekündigt hier noch ein Posting zu meinen aktuellen Gehversuchen mit KDE4. Inzwischen gabs am Laptop eine erneute Testinstallation, diesmal gleich gefolgt vom Einspielen der aktuellen KDE 4.5 Pakete. Und mein erster Eindruck, KDE verhält sich auch auf meinem System nun stabiler.

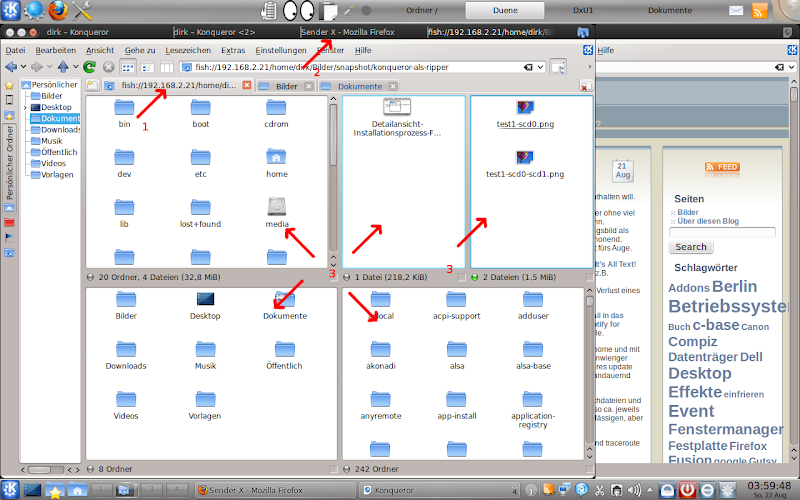

Zunächst nochmal ein paar Zeilen zu Tabs im Konqueror und in KDE4.

Eine meiner ersten Anpassungen nach der Installation, war der Wechsel von Dolphin zu Konqueror als Standard-Filemanager (Systemeinstellungen | Erscheinungsbild und Verhalten der Arbeitsfläche | Standard-Komponenten | Dateimanager)

Konqueorer starte ich mit dem Profil ‚Dateiverwaltung‘. Hier tritt bereits ein erstes Problem auf. Gewöhnt aus KDE 3 Zeiten will ich auch hier (über den Menüeditor) Konqueror die Tastenkombination ‚Meta+E‘ (ja liebe M$ Jünger, der Windows-Explorer hört ebenfalls auf ‚Win+E‘) hinzufügen, dieses Zuweisen ist auch in KDE4 möglich nur startet eben der Konqueror nicht per Tastenkombination.

Ansonsten, macht es aber auch unter KDE4 Freude mit dem Konqueor als Filemanager zu arbeiten, Dolphin ist einfach nicht mein Fall. Schnell noch der Werkzeugleiste die Buttons zum horizontalen und vertikalen Teilen und entfernen der aktuellen Ansicht hinzugefügt…

…und schon lässt sich die Ansicht beliebig oft vertikal und horizontal splitten, wie im folgenden Bild unter _3_ zu sehen. Sehr praktisch zum kopieren, verschieben und verlinken von Dateien und Verzeichnissen

Werden es zu viel gesplittete Fenster, sind natürlich weiterhin Tabs möglich und auch zwischen diesen ist per ‚Drag and Drop‘ das Filemanagement wie erwähnt möglich. Quelle auf einen Tab ziehen, warten, bis sich dieser aktiviert und dort wieder über dem gewünschten Zielordner halten und warten, bzw. bei erreichtem Ziel los lassen. Diese Technik ist sicher den meisten bekannt, meines Wissens zuerst von Apple eingeführt und hörte dort auf den Namen ’spring loaded Folders‘. Inzwischen nichts neues mehr, aber gerade für Einsteiger immer wieder erwähnenswert und eine schöne Alternative zum Kontextmenü – basierten arbeiten oder die alt bekannten Tastenkombinationen zum auschneiden, kopieren und Einfügen. Und nur der Vollständigkeit halber: beim fallen lassen eines Objektes bietet ein Dialog auch hier die Wahl zwischen verschieben, kopieren, verknüpfen oder abbrechen der Aktion.

Ok ich schweife ab. Wie im nächsten Bild zu sehen _2_ , bietet KDE4 nicht nur die Tabs innerhalb von Anwendungen, sondern auch das tabben der Fenster selber. Probiere es doch mal. Greife einen Fenstertitel mit der mittleren Maustaste und zieh ihn auf einen anderen Fenstertitel. So kannst du Fenster recht platzsparend (z.B. thematisch) zusammenfassen und diese auch gemeinsam über den Desktop bewegen.

Irgendwann erschien nach demLogin wie aus dem nichts ein nichtssagendes Fenster

- wird das Fenster etwas aufgezogen, ist auch nicht mehr zu sehen, ausser der missglückte Versuch den Hintergrund dort neu zu rendern

Das Dumme war nur eben, beim Beenden des Fensters verschwand, ebenfalls reprodzuierbar, der Fenstermanager/Plasmaoberfläche/Desktopmanager/Panels. Übrig bleibt ein schwarzer Desktop…

…der aber noch ermöglicht z.B. per [Alt+F2] Anwendungen zu starten.

Inzwischen ist das Probelm verschwunden, aber besser man fasse das Miniprogramm „Arbeitsfläche (Standard-Arbeitsflächen-Behälter)“ nicht an, bis man weiss, wofür es gedacht ist. Auch hier freue ich mich über entsprechendes Feeback.

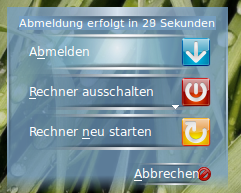

Ein weiteres Problem. Beim Drücken des Powerknopfes meines Laptops sollte eigentlich dieser Dialog erscheinen:

- Stattdessen fährt das System sang- und klanglos runter, ob dabei entsprechende Dateien noch gesichert und Anwendungen sauber beendet werden ist fraglich.

- Lediglich das entsprechende Miniprogramm „Bildschirmsperre und Abmeldung aus KDE“, so es denn ins Panel eingefügt wurde, ermöglicht den entsprechenden Dialog.

- Alle Einstellungen in der Energieverwaltung habe ich sicherheitshalber so eingestellt, dass beim betätigen der Powertaste genau dieser gewünschte Dialog erscheint. Aber erfolglos. An der Hardware wird es kaum liegen, schliesslich funktioniert Selbiges unter gnome tadellos.

- @update: beim letzten Stammtisch von Ubuntu-berlin, wurde dieses problem auf einem ähnlichen Laptopmodell von Dell nachgestellt, dort funktioniert es wie gewünscht.

-

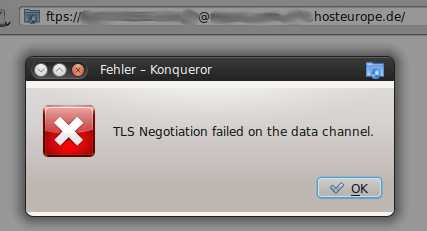

Auch unter KDE4 klappt mit Konqueror kein Login per ftps ….und das Ergebnis ist bedauerlich.

Also neues Spiel neues Glück, die nächste KDE4 Version kommt bestimmt und wird es wert sein erneut getestet zu werden.

(K)rüße DxU

Besonders frohlockte ich mit der Ankündigung der kio für ftps. Meine Seiten liegen auf Servern von HostEurope. Leider bietet das gebuchte Paket kein sftp, wohl aber ftps an und somit war der Filetransfer mit dem Konqueror immer nur unverschlüsselt möglich. Alternativen waren filezilla, kasablanca, fireftp (ein FTP Client als Addon für Firefox realisiert) und andere ftps-fähige Clients. (Kann Midnight Commander eigentlich ftps?). Nun aber bekam Konqueror eine entsprechende Schnittstelle….

KDE 4 – Never ending Story

Ich habe ja seit der ersten Version von KDE4 (irgendwann 2008) immer wieder versucht mich damit anzufreunden. Nun im April 2008 erschien Ubuntu 8.04 LTS. Dazu gab es auch ein Kubuntu wahlweise noch mit KDE 3.5.irgendwas…. (wow die 3.5er serie gibt es laut diesem Wikieintrag schon seit fast 5 Jahren. Unglaublich) und alternativ das neue KDE4.0. Allerdings bekam diese Kubuntu diesmal nicht das Prädikat Long Term Support (LTS), aus nachvollziehbaren Gründen. Einerseits war KDE 3 ein Auslaufmodell und andererseits war KDE 4.0 eben noch lange nicht soweit LTS tauglich zu sein. Das wurde von Entwicklern auch unumwunden gesagt. Aussagen wie „KDE4.0 ist nicht KDE4“ und „KDE4.0 ist eine Entwicklerversion und nicht für Endanwender und Produktivsysteme gedacht“ (sinngemäße Wiedergabe) waren wiederholt zu lesen. Nun, es folgte Version auf Version, jedesmal, so habe ich es in Erinnerung, mit der Suggestion wenn nicht Versprechen, jetzt ein stabiles, Endanwender-taugliches KDE4 zu präsentieren. Aber Pustekuchen. Allen Behauptungen zum Trotz, konnte ich bisher noch kein dauerhaft stabiles KDE 4 entdecken. Ein upgrade von älteren Versionen ob nun von KDE3 oder aber innerhalb KDE4 egrab bei mir immer nur ein instabiles, wackeliges zum Teil unbrauchbares System. Abstürze, hängende Anwendungen und der nervige KDE-Crashmanager, ließen mich immer wieder an obige Sätze zu KDE4.0 erinnern. Es fühlte sich alles irgendwie wie in einem Debug-Modus an, aber nicht wie ein Produktivsystem. Ein falscher oder zu schneller Klick und Komponenten des Desktops straften sogleich. Wenige Konfigurationsversuche an der Oberfläche und das System schmierte ab. Der Anwender, so schien es, mußte sich nach dem System richten und nicht umgekehrt.

Stundenlang saß ich dann mit anderen Anwendern vor einem Kubuntu 9.10 und rätselte warum sich dieses oder jenes Tool so störrisch verhielt. Einen neuen Benutzer angelegt und somit „jungfräuliche“ user-speziefische Einstellungen hielten einem Test nur kurzweilig stand.

Im Gegensatz dazu, hier zuhause am Tower läuft noch immer ein Kubuntu 8.04 mit KDE3 inzwischen seit geraumer Zeit in Version 3.5.10. Kleine Ungereimtheiten, hängende Programme, seltene Abstürze, sowas kenne ich auch von anderen Systemen, ob nun Gnome, Xfce oder eine andere Desktop-Umgebung, ob nun Ubuntu oder eine andere Distribution ob nun Linux oder ein anderes Betriebssystem, Fehler passieren überall und der größte Fehler sitzt oft vor dem Rechner und bedient selbigen 😉

Hinzu kommt bei meinem Produktivsystemn, viel eigene Bastelei, die nicht immer zu dessen Stabilität beitrugen, eine Menge Fremdquellen und natürlich massig Nicht-KDE-Anwendungen. Aber im Großen und Ganzen, kann ich mit dem System arbeiten, kann mich darauf verlassen und etwaige Fehler sind auch für mich nicht irreparabel.

Nun kam Kubunt 10.04 und mein Wagnis während der LinuxTage (ich berichtete). Wow, meine Skepsis wich schnell Bewunderung. Sollten es die KDE’ler wirklich geschafft haben. Das System funktioniert, es ist stabil, vielleicht weniger intuitiv alsKDE3 oder Gnome, dafür sehr verspielt, bringt es viele Features mit. Es zwingt zum Umdenken gerade mich als eingefleischten KDE3 Fan. Nicht alles gefällt mir, manches wirkt überladen, an so einigen Stellen fehlt noch der letzte Schliff, aber es gefällt mir und erstmal gewinne ich den Eindruck: Ja KDE4 ist auch für mich bereit.

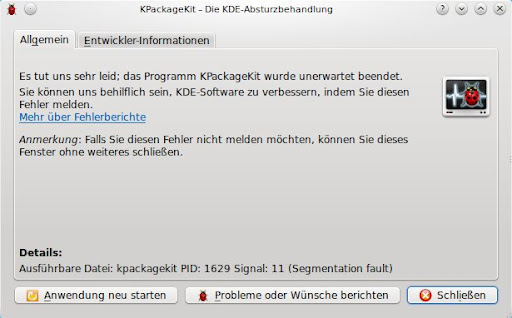

Leider erschien schon nach der ersten Nutzung von KpackageKit wieder der verdammte Crashmanager

Aber hey, so schnell lasse ich mich ja nicht entmutigen.

Und da mir Kpackagekit eh noch nie zusagte, bzw. ich noch nichts besseres als Synaptic (ein Spitzen Tool!) gefunden habe, war das ruckzuck nachinstalliert.

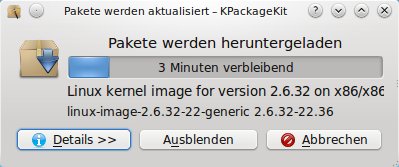

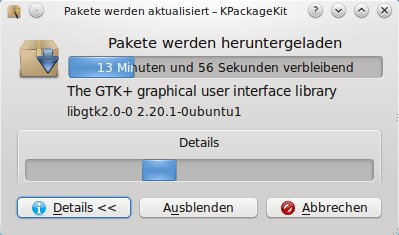

Apropos KpackageKit, sicher ist es gewöhnungsbedürftig und sicher hat es auch seine Vorteile aber im Fortschrittsdialog der Button „Details“ verdient den Namen nicht

Lediglich ein weiterer Balken erscheint, der hin- und herwandert und somit immerhin eine noch vorhandene Aktivität anzeigt. Hier hätte ich mehr erwartet, z.B ein Terminalausschnitt der aktuellen Abläufe, wie z.B. bei Synaptic.

Auch hier kann ich aber mit leben, die Entwickler werden sich schon was dabei gedacht haben.

Inzwischen bekam ich noch den Tipp, doch mal das aktuelle stabile KDE 4.4.4 aus dem PPA zu installieren, gesagt, getan, alles lief prima, alles ging glatt.

Sollte ich hier wirklich endlich den heiss ersehnten Nachfolger des stabilen, anwenderfreundlichen KDE 3.5.10 vor mir haben? Nun ich bin immer noch kein Freund von Dolphin, aber zum Glück verrichtet Konqueror nicht nur als Webbrowser sondern auch optional als Filemanager weiterhin seinen Dienst. Es gibt inzwischen sogar (wieder?) eine kio für ftps. Lange habe ich mich danach gesehnt, da mein Webhoster leider kein sftp wohl aber ftps anbietet, dieses aber bisher von KDE nur stiefmütterlich behandelt wurde.

Nachtrag: Dieses Posting lag aus Zeitgründen jetzt mehrere Wochen in meinem Dashboard und wartete auf Vollendung. Betrübt musste ich aber kurz nach diesen Zeilen feststellen, auch diese Installation von Kubuntu mit KDE4 ist in meinen Augen nicht als Produktivsystem geeignet. So verabschiedete sich irgendwann beim Neustart des System nach dem Login der Windowmanager komplett und ichhabe noch kien Möglichkeit gefunden, diesen zu reaktiviern. Alle Fenster haben somit keinen Rahmen und sind nicht managebar. Alle Desktop-Tools sind nicht mehr zu sehen, keine Kontrollleiste keine Arbeitsfläche, kein Wallpaper…nichts. Eine schwarze Oberfläche, sonst nix. Immerhin Alt+F2 ermöglicht noch Eingaben über krunner.

Bisher habe ich dafür keine Lösung gefunden. Als nächstes richte ich mal einen neuen User ein und prüfe, wie sich das System beim Login mit diesem verhält. Sicher war das nicht der letzte Versuch mit kde4. Aber ein weiterer Rückschlag.

Hinnfallen, wieder Aufstehen

Grüße DxU

Nachtrag 2: Obiger versuch mit einem neu eingerichteten User brachten auch kein Erfolg, auch da verhält sich der Desktop wie beschrieben.

Diese Woche brachte ![]() einen mehrseitigen Beitrag zum heiss erwarteten und nun wohl am 10.August endgültig erscheinenden KDE SC 4.5. Es klingt viel versprechend und weckt neue Hoffnung, dass auch bei mir endlich KDE4 rockt.

einen mehrseitigen Beitrag zum heiss erwarteten und nun wohl am 10.August endgültig erscheinenden KDE SC 4.5. Es klingt viel versprechend und weckt neue Hoffnung, dass auch bei mir endlich KDE4 rockt.

Wenn der Desktop einfriert

Aktivitäten auf der grafischen Oberfläche sind noch zu sehen, so läuft die Uhr oder der Systemmonitor (aus superkaramba)

weiter.

weiter.

Auch die Maus läßt sich bewegen, aber es kann damit oder der Tastatur sonst keine Aktion ausgeführt werden.

Alle noch offenen Fenster haben einen scheinbar verfärbten eingefrorenen Fenstermanager oder Fensterdekorator (die Begriffe nutze ich warscheinlich manchmal nicht korrekt, gemeint ist halt die Umrandung gängiger Fenster,mit den typischen Buttons zum schließen, minimieren, maximieren, wiederherstellen, anpinnen, ….. und dem Anzeigen des Fenster-/Programmnamens)

Letztlich blieb mir immer nur übrig den X-Server abzuschießen, was häufig das ganze System in Mitleidenschaft zog.

Nun den Verantwortlichen für dieses Dilemma habe ich bis heute nicht identifiziert.

Immerhin aber habe ich (warscheinlich) eine Not-Lösung für das Dilemma gefunden.

- Zum einen konnte ich mich noch irgendwie erinnern, daß für die obige Darstellung ein Fenstermanager verantwortlich ist, unter KDE ist das kwin.

- Und irgendwie gab es da doch eine Option –replace

- Und da ich im X-Window ja nichts mehr machen konnte, muß der Befehl irgendwie dahingeschickt werden

- Mit [Alt+F1] verlasse ich zeitweilig den Windowmanager

- im Terminal login und dann

- kwin –replace eingegeben

- Antwort: cannot connect to X server

- ???

- Da gab es doch eine Option…aaah -display

- also kwin –replace -display :0 & (übersetzt ersetze den Fenstermanager auf lokalen erstern X und führe das ganze im Hintergrund aus)

- und siehe da, meine Programm unter KDE sahen wieder so aus wie vorher und ließen sich auch entsprechend bedienen.

Nun, das Ganze werde ich beim nächsten gleichartigen Ärgernis mal versuchen nachzuvollziehen.

Gespannt bin ich , ob das geschilderte Problem nur unter KDE oder vielleicht nur mit dem derzeit von mir genutzten propritären ATI-AMD Treiber für meine Radeon X1300 auftritt. Dieser ist ja inzwischen im aktuellen (k)ubuntu 9.10 für meine Karte nicht mehr nötig und sehr gut durch den freien Treiber ersetzt, so daß die Karte samt 3D-Hardwarebeschleunigung dort out-of-the-box funktioniert.

Auf meinem Laptop und Netbook habe ich vergleichbares noch nicht

beobachtet, allerdings laufen dort aktuellere Ubuntu-Versionen, kein

KDE und sie sind beide mit Intel-Grafikchips bestückt.

Es bleibt spannend.

Liebe Leser, gerade zu diesem Posting bitte ich um Kommentare mit sachdienlichen Hinweisen.

Danke und Grüße DxU

Nachtrag 07.01.2010:

Ich habe jetzt einige male bei Eintreten des beschriebenen Effektes den Befehl angewendet. Es funktioniert, aber nicht zuverlässig.

So ist es z.B. passiert, dass der Fenstermanager wieder erscheint und auch Mausfunktionen uneingeschränkt ausgeführt werden können, dafür reagiert dann aber die Tastatur nicht mehr.

Zwar ist auch das extrem unbefriedigend, aber immerhin läßt sich so das System mit der Maus noch sauber runterfahren bzw. rebooten.

Hardware unter Linux und 15 Jahre WWW

Passend dazu habe ich vor einigen Tagen eine neue Erfahrung zum Thema Linux und Hardware“ machen „dürfen“. Mein alter 500 Mhz Rechner mit 2 klassischen IDE Festplatten und ebensolchen CD-Laufwerken. Nach einem Upgrade von Gutsy auf Hardy-LTS werden plötzlich die Laufwerke und Partitionen nicht mehr erkannt. Da ich in der Vergangenheit beim installieren anderer Systeme (wobei meißt die SWAP Partition ungefragt neu formatiert wird und sich ihre UUID ändert) oder umpartitonieren mit der Zuweisung in der „/etc/fstab“ Probleme mit den UUID’s bekommen habe, konnte ich mich mit dieser Art der Gerätezuweisung nie so Recht anfreunden. Nun aber werden die klassischen „/dev/hdX“ nicht mehr erkannt, nur noch meine /dev/hda3 wird als „/“ Partition im Notfallmodus gemountet. Gestern dann in der c-base beim Treff der Ubuntu-Berlin Gruppe (Vortrag ‚Konsolen-Klempnerei und Besprechung für den Grillabend nach dem LinuxTag.org am 31.5.) tollen Tipp bekommen. Das Zauberwort heißt „blkid“ und Problem erkannt, Problem gebannt. Tja auch IDE-Devices werden inzwischen nur noch über SCSI-Namen (z.B. „dev/sda3“) angesprochen, also die fstab entsprechend der Ausgabe angepaßt und schon war alles wieder schick.

Apropos Golem.de

Anläßlich des 15 jährigen Besthens des WWW gab es eine lesenswerte Artikelserie zum selbigen Thema und mir wurde mal wieder klar WWW ist nicht das Internet alleine.

Hier die Artikel im Einzelnen:

15 Jahre WWW: Internetdienste im Wandel der Zeit

Am 30.4.1993 gab das CERN (siehe auch Artikel bei Wikipedia) die sogenannte libwww frei und das WorldWideWeb trat seinen Siegeszug an.

15 Jahre WWW: Die Browserkriege

Nochmal ein Rückblick über den viel zitierten Kampf zwischen Netscape und den Redmonder Brow$er, Alternativen und der weiteren geschichte von Mozilla und Firefox.

15 Jahre WWW: Von Browsern und Bremsern

Ein Überblick über Vergangenheit, Gegenwart und Zukunft von Webstandards und deren Inkopatibilitäten bei diversen Browsern.

WorlWideWeb Grüße DXU